torch常用命令

1、服务器信息查询

CPU查询

1 | 查看CPU信息 |

GPU查询

1 | 查看GPU信息 |

lspci是一种实用程序,用于在系统中显示有关pci总线的信息以及连接到它们的设备。

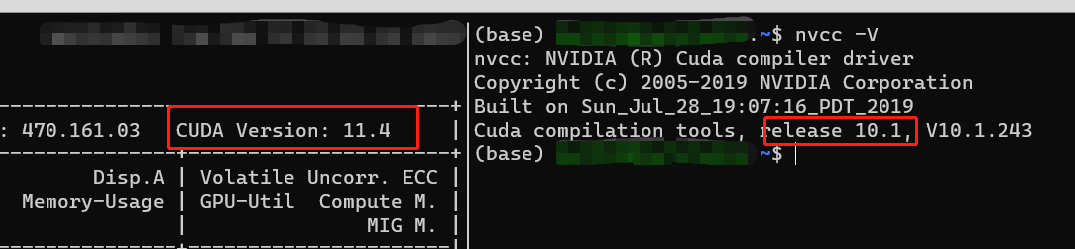

CUDA版本

1 | nvidia-smi # 右上角CUDA Version,但可能不准确,推荐使用nvcc -V |

实时查看nvidia-smi

1 | nvidia-smi -l 1 # 以每秒刷新一次进行信息,结果为1s一次输出nvidia-smi,不流畅,建议使用吓一条命令 |

2、显卡信息查看

1 | torch.cuda.is_available() # 查看是否有可用GPU |

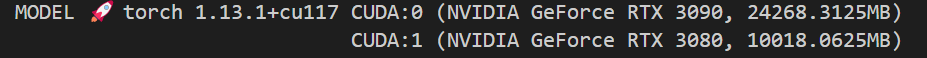

3、输出模型增肌信息

1 | s = f'MODEL 🚀 torch {torch.__version__} ' |

4、指定使用显卡

通过os.environ["CUDA_VISIBLE_DEVICES"]指定所要使用的显卡:

1 | import os |

这种设置方式,2号卡就变成了主卡。CUDA_VISIBLE_DEVICES 表示当前可以被python环境程序检测到的显卡。os.environ["CUDA_VISIBLE_DEVICES"] = "2,1,3,4"进行指定使用设备,这样会修改pytorch感受的设备编号,pytorch感知的编号还是从device:0开始。如上会把2号显卡改为device:0,1号显卡改为device:1。

如果有多个显卡,设置了os.environ["CUDA_VISIBLE_DEVICES"]后,其他没有设置的显卡将不会在本次代码中显示。os.environ["CUDA_VISIBLE_DEVICES"]需要设置在代码开头。

另外,使用终端也可以直接选择选择显卡,输入CUDA_VISIBLE_DEVICES=0 python train.py也可以

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 花火の红玉宫!

评论